2019年5月15日に、データを中心とした新しい経済に関する取組みをする2社、コラボゲートとOcean Protocolがミートアップを行いました。Ocean Protocolについては、直近でBittrexがIEOを行ったことでも話題になっています。

イベントページ:Unlocking Barriers to Data Sharing by CollaboGate and Ocean Protocol

[the_ad id=”13126″]

コラボゲートからのプレゼンテーション

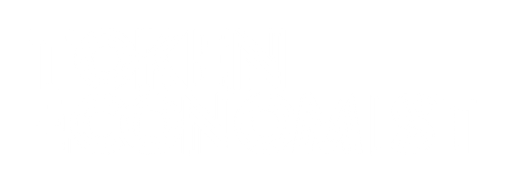

コラボゲートからのプレゼンテーションでは、大阪代表の四條能伸氏から政府の科学技術政策であるSociety5.0について語られました。

Society5.0で重視しているのが、サイバー空間と物理空間を組み合わせて様々な社会課題を解決するということです。クラウド環境に集まっている情報の密度を高め、そこに集まったビッグデータを使い、高付加価値のものを作って物理空間にフィードバックすることを行います。

現状は、クラウドに情報が集まっているものの、そこに貯まっているデータがお互いに分離している状況になっています。そこで、まずはそのデータ同士を接続連携させ、スキル向上や生産性を向上、技術共有ができる段階に持っていきます。そのために必要なのが、まずはインフラの整備になってきます。

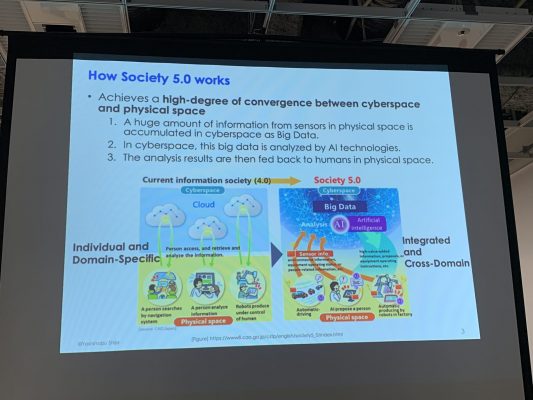

インフラでは、個人のデータを保管するPDS(Personal Data Store)が必要になります。ユーザが手元でデータを保管する場合もあれば、どこかに集中的に保管する場合もあります。PDSには、自分の指定した情報のみを渡すことができる機能がついています。しかし、ここからそのままデータを売買するのはまだ容易ではありません。そのための情報銀行を用意します。

情報銀行はPDSとデータを活用したい企業の間に位置する存在です。ユーザは情報銀行に自分のデータと条件をあらかじめ提供しておき、その条件に基づいて情報が売買されます。

データ交換マーケットでは、企業がデータを購入することができます。これにより、個人情報がより資産性を帯びてきます。

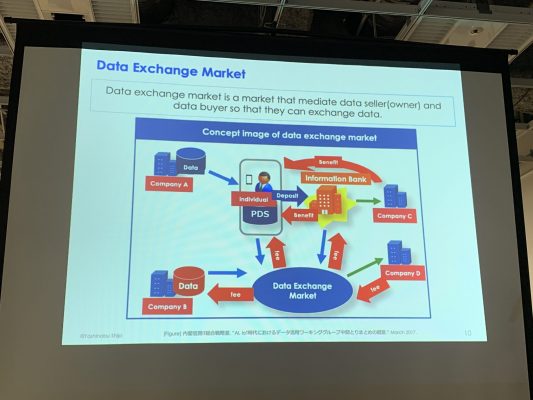

しかし、これらをやる上で検証しなければいけないことが存在しています。データ交換マーケットは、果して効率的か、データは信頼されるものか、関わっている会社が信頼できるものなのか、本当にデータを活用できるのかなどです。

データ交換マーケットの効率性を高めるものとして、データスタンダードモデルやデータ・フォーマットアダプターがあります。これらを使うことにより、データを活用可能な型に整え、活用しやすくします。

また、データが信頼できるだけの品質があるのかについては、現在様々な方法が検討されています。この他、そのデータを本当に信頼できる会社に預けようとすると、預けられる先が限られてデータが有効に活用しないという弊害が起きます。

そのようなことを踏まえ、四条氏は分散型のデータ売買マーケットにするのが良い解決策であると語りました。

コラボゲートに関する情報

[the_ad id=”7916″]

Ocean Protocolからのプレゼンテーション

Ocean Protocolは、FounderのDaryl Arnold氏がその取組みを紹介しました。

現在のデータ市場は巨大になっており、2030年までには3.8兆ドルの経済規模になると言われています。しかし、世界の上位IT企業のGAFAがこれらの利益を独占しようとしている流れになっています。Daryl氏は、多くの人が参加することでこの流れを変えなければいけないと考えています。

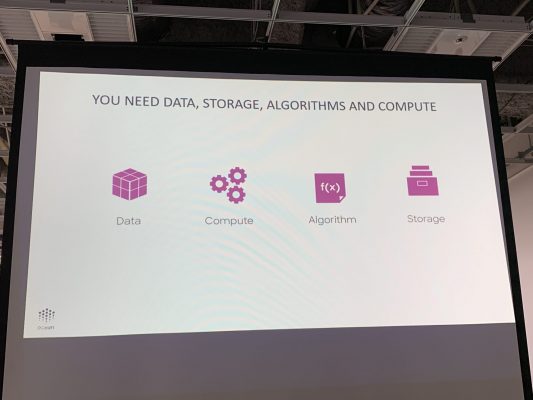

データを民主化するためには、もちろんデータが必要になります。そして、それを処理するためのコンピュータやアルゴリズム、データの保管場所が必要になります。これらを包括的に用意できる企業は現状一部に限られ、多くの企業の情報はそれぞれが分離保管された状態になっています。

Ocean Protocolでは、データを保管場所に置いたままで、データを処理し活用できるようにします。つまり、情報漏えいが起きないということになります。また、実際のデータ処理やデータのクリーニングはすべてブロックチェーン上で行われます。これらの処理は監査を受けているため透明性が確保できるといいます。

Ocean Protocolの優位性を示す例として、パーキンソン病の治療があげられました。

一般的に医師の診断の正確性は高くなく、その精度は60%だといいます。

Ocean Protocolによる実証実験では、ウェアラブルデバイスから得られるヘルスケアデータを活用し、それを機械学習にかけることを行いました。内容が難しいので割愛しますが、結果的に80%のデータは正しく、許容できるデータが12%、使えないデータが7%となりました。これは医師による診断の精度より高いものになります。つまり、リッチなデータが無くても大丈夫だということになります。

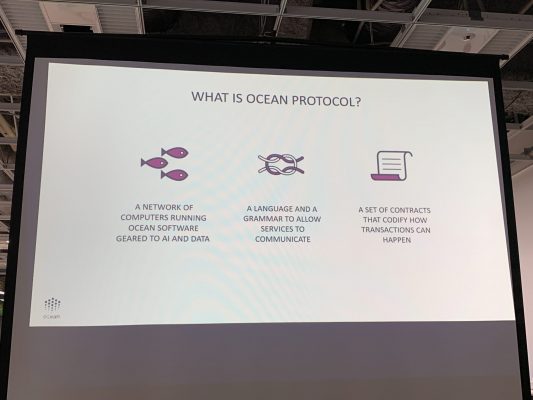

Ocean Protocolでは、データのプライバシーを確保し、有効なデータを扱えるようにし、それらを売買できることを目指しています。そのために、Oceanネットワークや、サービスが協調できるための言語や、トランザクションのための体系化されたコントラクトが用意されています。

これにより、アルゴリズム作成者は複数のデータセットのモデルを処理できるようになります。また、データ所有者は自分のデータのアクセスや管理権限を、自分でコントロールすることができるようになます。データサイエンティストは、自分たちの独自データ分析パイプラインを構成することができます。

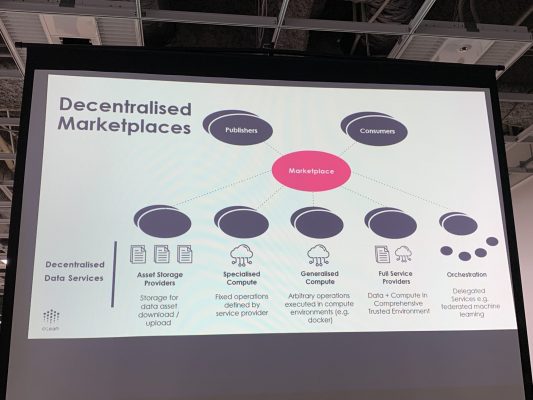

これらの一連要素により、オープンで標準化され、分散的に責任を管理し、信頼性のあるデータを使いそれらを強調させ、データの追跡ができるようになります。また、分散型マーケットプレイスによりデータの売買もできるようになります。

Ocean Protocolは、すべてオープンソースで提供されています。既に官民の様々なコミュニティを提携し、データの有効利用に関する取り組みをしています。